In the project group knowAAN our goal is to analyze the data of scientific publications. These publications are often offered in the PDF. As we need a data format, which is accepted for inputs of large parts of software, our first step is to transform the PDF into a suitable format. This format is plain text, which can be used as an input for the majority of extraction tools.

For one branch of our analysis of data, we chose the extraction tool ParsCit. ParsCit generates useful outputs: Metadata, the logical structure of a publication, and different fields of the reference-part of publications (e.g. authors, title, date). We use these extracted data for further analysis.

For the extraction of references there exist different approaches. ParsCit „is architected as a supervised machine learning procedure that uses Conditional Random Fields as its learning mechanism“. You can train ParsCit with a set of data to generate a foundation to extract metadata of similar inputs. This means that the outcome of the extraction process highly depends on the used train data.

We are interested in results of special research fields. Therefore the idea of analyzing whole journals came up. Such a journal can exist since 10 years with 3 issues a year and 10 publications per issue. This produces a set of 300 publications. For the special case of analyzing a journal, it is obvious to train ParsCit especially for the publications of the journal.

After testing some approaches, we developed heuristics for the training of ParsCit to parse journals. These heuristics consist of a gradual and iterative process of creating input data and perform a training.

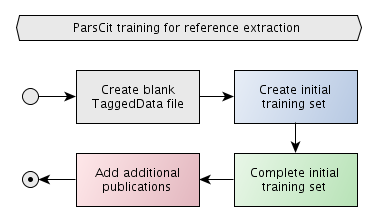

The first step is to create a blank file for tagged data. This file is the human-readable training set of ParsCit. We will gradually add data to the file to produce well parsing results and keep the file small. In the first step we have to create an initial training set. After a first training, this set is completed by adding additional references, which were parsed incorrectly. After the initial set is completed, there is the option to add additional publications.

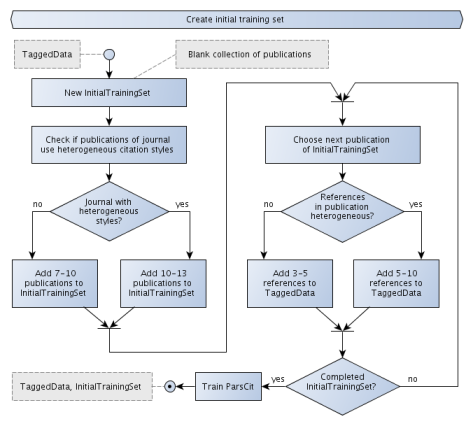

The creation of the initial training set starts with a choice of some publications of the journal. In most cases publications of a journal use the same citation style. A set of 7 to 10 publications is a good start for a homogeneous citation style. If there are some publications which use different citation styles, the use of up to 13 publications results in a better quality. For each of the chosen publications we choose 3 to 5 references and add them to the tagged data file. In some cases there are publications with very heterogeneous references. We got better results, if we added up to 10 references for those publications. The initial set should consist of at least 21 lines of tagged data. The last sub-step is to train ParsCit with the generated tagged data.

After the creation of the fist model, we have a look at the parsing results of the initial chosen publications. If the results are satisfiable, this step can be skipped. If not, we choose 5 publications of the initial set with incorrectly parsed references. Following, we choose 3 to 4 incorrectly parsed references of each publication, add the correct values to the tagged data file, and train ParsCit. These steps are repeated until all files of the initial set of publications is parsed correctly.

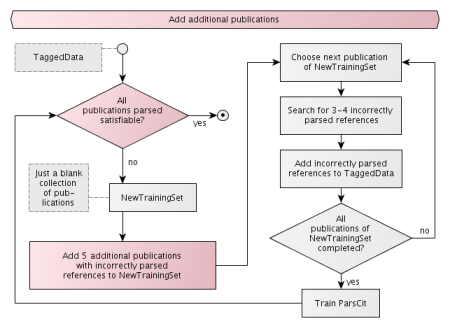

The last step is equal to the previous step, except that publications of the journal, which have not been in the initial training set, are used. We collect a set of publications, choose incorrect parsed references, add the correct data to the tagged data file, and train ParsCit.

Following these steps, you will generate an useful model. It is also to mention that we achieved good results in combining training sets of different journals.

Aufbauend auf den Ergebnissen der PG knowAAN wird ab dem kommenden Semester die PG PUSHPIN durchgeführt. Die Vorstellungsfolien sind bereits auf Slideshare, Anmeldungen werden ab sofort angenommen.

In unserer Adaption der agilen Softwareentwicklung haben wir Iterationen festgelegt, in denen (Teil-) Prototypen entwickelt werden. Zurzeit befinden wir uns in der dritten Iteration und haben Grundlagen, wie die Installation eines Redmine und verschiedene Server-Basics, sowie die ersten beiden Prototypen abgeschlossen.

Aus Benutzersicht beginnt der zweite Prototyp mit einer Möglichkeit des Uploads einer Publikation im PDF-Format. Diese PDF-Datei wird auf dem Server gespeichert und der Reintext extrahiert. Dieser Reintext wird intern weitergegeben und analysiert. Unter anderem werden verschiedene Abschnitte, Überschriften, Metadaten und der Referenzteil einer Publikation erkannt. Aus den Metadaten werden Felder wie Autoren oder der Titel der Publikation extrahiert; Angaben zu Zitaten aus dem Referenzteil werden nach Autoren, Titel der Arbeit, Erscheinungsjahr, etc. zerlegt. Dies geschieht ohne menschliches Eingreifen, die Maschine macht Vorschläge für die einzelnen Bestandteile, die dem Benutzer zur Überprüfung in einem Formular präsentiert werden. Nachdem ein Benutzer die ihm vorgegeben Felder korrigiert, oder mangels Motivation das Formular zumindest abgesendet hat, werden die Daten in einer Datenbank abgelegt. In diesem Schritt werden gleichzeitig szientrometrische Maße berechnet, die später Aufschluss über Zusammenhänge der Publikationen oder Autoren geben sollen.

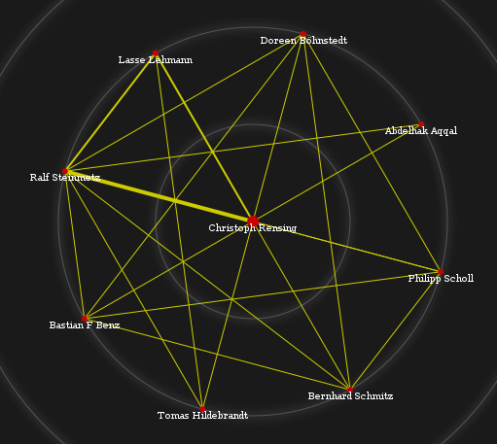

Die extrahierten und generierten Daten können nun genutzt werden, um Benutzern des Systems semantische Daten anzubieten. Das heißt, dass die aufbereiteten Daten etwas aussagen und einen gewissen Mehrwert bieten sollen. Ist dem Benutzer z.B. ein Autor bekannt, so kann er sich Daten zur Mehrautorenschaft anzeigen lassen. Wir präsentieren dies in einem interaktiven Graph. In der folgenden Grafik sind verschiedene Autoren als Knoten dargestellt. Der Knoten in der Mitte ist der Ausgangspunkt – der Autor, für den sich der Nutzer interessiert. Die Kanten repräsentieren den Grad der Zusammenarbeit zweier Autoren. Eine dünne Linie sagt aus, dass die Autoren zumindest eine Publikation zusammen veröffentlicht haben. Die Kante, die vom Ursprung Richtung Westen liegt zeigt an, dass die verbundenen Autoren mehrere Publikationen miteinander verfasst haben. So eine Visualisierung kann interessant sein, wenn man einen bestimmten Autor schätzt und interessiert an Autoren ist, die vielleicht ähnliche Publikationen verfasst haben.

Ein anderes Maß ist die bibliografische Kopplung. Hier wählt man eine Publikation X aus und ist interessiert an anderen, inhaltlich ähnlichen Dokumenten, z.B. einem Dokument Y. Ein Indikator für die inhaltliche Ähnlichkeit ist die Anzahl an Dokumenten, die zugleich im Referenzteil von X, als auch im Referenzteil von Y auftauchen. Wir nehmen an, dass zwei Dokumente, die beide aus gleichen anderen Dokumenten zitieren, inhaltlich ähnlich sind. Eine erste Visualisierung zeigt die folgende Grafik. Die Kantenstärke gibt – wer hätte es gedacht – die bibliografische Kopplung wieder.

Es ist geplant, dass ein Benutzer auf einen beliebigen Knoten klicken kann, die Daten für diesen Knoten nachgeladen werden, und der Graph mittels Morphing umgestaltet wird. Eine der größten Hürden stellt im Moment noch die automatisierte und korrekte Extraktion der verschiedenen Teile (Autoren, Titel, Zitate, …) einer Publikation dar. Diese Daten werden benötigt, um die korrekte Verlinkung der Publikationen zu gewährleisten. Es ist geplant, dazu maschinelles Lernen zu verwenden. Also Namen oder Titel von Publikationen vorzugeben und der Maschine damit eine Möglichkeit zu verschaffen, zukünftig ähnlich aufgebaute Zeichenfolgen erfolgreich als Titel etc. zu identifizieren. Unter anderem liegt der Schwerpunkt unser derzeitigen Iteration aber auf dem Clustern von Daten.

Schaut mal rein in die Präsi. Speziell wenn es um die Zugangszeiten und den Fakt, dass ständig gecountet werden muss wird es interessant für uns….

Nach dem grandiosen Superbowl gestern, möchte ich mal wieder eine sehr ansprechende Darstellung von zeitlichen Verläufen mit Euch teilen. Auf http://sbtwitter.nfl.com/matchup/ sind Tweets der jeweiligen Mannschaft zugeordnet, zusätzlich werden aus den Inhalten relevante Terme extrahiert und mit der Zeitleiste kann man super sehen, wie sich sowohl die Anteile und Terme weiterentwickelt haben.

Kommentare?

Im Kreativitätsworkshop kam unter anderem die Frage auf, was man alles mit Bibliometrics machen kann. Dazu hier eine echt gute Präsentation (insbesondere die verschiedenen Statistiken ab Slide 22.

Außerdem kam die Idee auf, dass man doch Forscher eindeutig über eine ID identifizieren können müsste. Auch in der obigen Präsentation ist der Service ResearcherID.com genannt, mit dem genau das möglich sein soll.

ResearcherID is a global, multi-disciplinary scholarly research community. With a unique identifier assigned to each author in ResearcherID, you can eliminate author misidentification and view an author’s citation metrics instantly. Search the registry to find collaborators, review publication lists and explore how research is used around the world.

Ich habe mich mal registriert und werde nun testen, wie ich die ID sinnvoll in eines meiner kommenden Paper integriert bekomme.

Hier noch ein paar Ressourcen, die zeigen, was in der visuellen Analyse so alles möglich ist und Links zu Quellen ständiger Inspiration bzgl. Visualisierungen.

- visual complexity

- density design

- flowing data

- neoformix

- data mining

- dataviz

- simple complexity

- moritz stefaner auf well-formed-data

- moritz stefaner’s portfolio

- information is beautiful

- Processing.js exhibition

- mace

- Smashing Magazine zum Thema Visualization

- Zwei Listen mit Visualisierungsbeispielen, Tools etc Link1 und Link2

Konkrete Beispiele

Durch unsere gestrige Diskussion zum Thema wie Trends in Publikationen visualisiert werden können, habe ich noch mal ein paar Suchen gestartet und möchte folgende Links zur Diskussion teilen. Trends können generell ja auch auf deskriptive Statistiken bezogen werden, ich gehe hier aber mehr auf Ansätze zur Visualisierung qualitativer Trends (der textuellen Inhalte, Keywords oder Tags) ein…

- SparkClouds: Visualizing Trends in Tag Clouds

- Visualizing Trends in Knowledge Management

- CiteSpace: Visualizing Patterns and Trends in Scientific Literature (Infos & WebStart zum Testen)

- EXTENDED VISUALIZATION FOR A DIGITAL JOURNAL

- Sehr interessante Videos im Blogpost Data Visualization: Show Me Forest, Not The Trees

- Trendvisualisierung in Microsoft Academic Search (Hilfeseite oder Live Seite)

Dann habe ich noch ein nettes Video zur 3D Visualisierung von Trends gefunden. Die BETA-Version von Tianamo kann nach Registrierung verwendet und getestet werden…

Da wir uns beim letzten Meeting mehr als einmal gefragt haben, wie man die AAN Daten hübsch aufbereiten kann, habe ich den Sonntag genutzt und mich nochmal umgeschaut. Dabei bin ich auf diesen Tech Talk gestoßen, der eigentlich keine Fragen offen lässt. Munzner beginnt mit verhältnismäßig kleinen Graphen und arbeitet sich zu einer Methode vor, die Graphen mit mehr als einer Millionen Knoten übersichtlich auf den Bildschirm bringen kann.

Praktisch umgesetzt sind diese Ideen in den Bibliotheken Protovis und dem JavaScript InfoVis Toolkit. Alles was wir jetzt noch brauchen ist eine JSON Schnittstelle zum AAN … .